W trakcie zaplanowanych prac eksperymentalnych nad rozwojem narzędzia do zarządzania danymi referencyjnymi w Sanmargar Team badałem, w jaki sposób agent AI może wspomagać proces edycji danych. Napotkałem przy tym na kilka trudności, nie tyle technicznych, co wynikających z obecnych ograniczeń dużych modeli językowych (LLM).

W poniższym artykule skupię się na jednym problemie – w mojej ocenie kluczowym – heurystycznej odpowiedzi AI.

Żeby zrozumieć wyzwanie jakie stoi przed nami przy wdrożeniu agentów AI do edycji danych, musimy zobaczyć różnicę między heurystyką a działaniem deterministycznym.

Trochę teorii - modele rozwiązań w edycji danych

Heurystyka to metoda znajdowania rozwiązania, która nie gwarantuje stuprocentowej poprawności, ale daje wynik o najwyższym prawdopodobieństwie bycia poprawnym.

Wbrew obiegowej opinii nie musi to być metoda uproszczona. W wielu przypadkach bywa wręcz bardziej złożona niż podejścia deterministyczne.

Heurystyki stosuje się tam, gdzie pełne, matematycznie pewne rozwiązanie byłoby zbyt wolne, zbyt kosztowne obliczeniowo lub wręcz niemożliwe.

Przykład:

Kiedy szukasz czegoś w sklepie, najpierw idziesz tam, gdzie najbardziej prawdopodobne jest znalezienie tej rzeczy, zamiast sukcesywnie przeczesywać alejki od początku do końca – to właśnie heurystyka.

Algorytm deterministyczny to „przepis”, który zawsze daje taki sam wynik, jeśli zaczyna z tymi samymi danymi. Nie ma w nim żadnego przypadku – wszystko jest przewidywalne i powtarzalne.

Przykład:

Dodajesz na kalkulatorze 2+2. Niezależnie od tego, ile razy to zrobisz, odpowiedzią zawsze będzie 4.

Modele AI, ze względu na swoją podstawę, bazują na algorytmach heurystycznych. Poza naszym promptem – czyli „daną wejściową” – wpływ na wynik mają między innymi możliwości obliczeniowe jednostki, na której działa model, oraz ogrom danych, na których model był uczony.

Praktyczne wyzwania

Projektując połączenie z agentem AI w MetastudioDRM, chciałem stworzyć rozwiązanie, które pozwoli Data Stewardowi edytować całe zestawy danych jednym poleceniem w języku naturalnym, zamiast tracić czas na ręczne wprowadzanie zmian w każdym rekordzie.

Przykład:

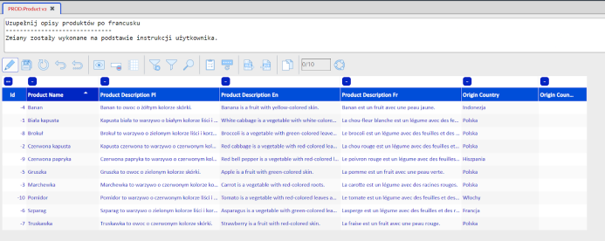

Mamy bazę produktów z opisami i chcemy dodać tłumaczenia nazw i opisów produktów np. na język francuski. Obecnie musieliśmy wykonać żmudną i czasochłonną pracę, czyli rekord po rekordzie modyfikować dane: skopiować opis po polsku, wkleić do Google Translate, a następnie wkleić z powrotem wersję przetłumaczoną do tabeli w Metastudio DRM.

Przy 10 rekordach jest to wykonalne, przy 100 już mniej, a przy 100 tys. niewykonalne dla jednego człowieka czy nawet zespołu.

I tu na ratunek pojawia się agent AI. Podajemy mu krótką komendę – „uzupełnij opisy produktów po francusku” – a po paru minutach mamy komplet gotowych danych.

Tylko pojawia się “ale”:

Czy dane są na pewno poprawne?

Czy uzupełnione zostały wszystkie rekordy?

W praktyce, dopóki tego nie przeanalizujemy, nie mamy pewności. A dokładna analiza to też nasz czas.

Wykluczenie danych nieuzupełnionych w takim przykładzie nie stanowi problemu – wystarczy przefiltrować po jednej kolumnie i znaleźć puste pola. Natomiast ocena, czy tłumaczenie jest poprawne, to już znacznie bardziej skomplikowana kwestia, nawet dla Data Stewarda znającego perfekcyjnie język źródłowy i docelowy.

Żeby to zweryfikować, musimy przeczytać wszystkie rekordy i zastanowić się, czy zostały poprawnie przetłumaczone. Oczywiście nadal jest to przyspieszenie pracy, bo tłumacz i tak musiałby te opisy przejrzeć.

Heurystyka w praktyce - brak powtarzalności

Ponieważ AI opiera się na heurystykach, ponowne wykonanie tej samej komendy – po odrzuceniu wcześniejszych zmian – może wygenerować inny wynik niż za pierwszym razem. Nie oznacza to, że wynik jest zły, a jedynie inny, ale wymaga to ponownego przeanalizowania przez tłumacza.

Jeśli dołożymy do tego naturalną skłonność użytkownika do skracania pracy – czyli przejrzenie kilku poprawnych rekordów i założenie, że reszta też jest w porządku – otrzymujemy prostą drogę do poważnych problemów z jakością danych.

O ile błędne tłumaczenia są mało groźne, o tyle ingerencja w słowniki wykorzystywane przez procesy ETL może prowadzić do poważnych błędów biznesowych, podwyższonego ryzyka finansowego a nawet dezorganizacji operacyjnej.

Jak wprowadzać AI do edycji danych

W zasadzie, by znaleźć rozwiązanie, problem trzeba rozbić na dwa:

- Zmiana dużej ilości danych

- W miarę powtarzalna odpowiedź przy podobnych danych wejściowych

Zmiana dużej ilości danych

Najważniejsze jest takie przedstawienie proponowanych zmian w danych przez AI, aby człowiek był w stanie w skończony i poprawny sposób je przejrzeć.

Jeśli dane można modyfikować za pomocą wyrażeń regexp, agent powinien zwrócić takie zapytanie wraz z przykładem, opisem i możliwością sprawdzenia go na danych testowych, które użytkownik może ręcznie zmienić. Dopiero wtedy użytkownik zatwierdza wprowadzenie zmian przez agenta AI.

Jeśli nie da się modyfikować danych skryptem – konieczne jest pogrupowanie zmian i przygotowanie raportu, co dokładnie stanie się po akceptacji.

Powtarzalność odpowiedzi

Kluczowe jest dobranie lub stworzenie modelu, który na potrzeby danych w rozwiązaniu takim jak Metastudio DRM będzie dawał możliwie najbardziej powtarzalne odpowiedzi, przy zachowaniu bezpieczeństwa i braku ryzyka wycieku danych.

Do uzyskania powtarzalności odpowiedzi potrzebne jest również to, aby agent AI uczył się sam – czyli budował wiedzę na podstawie odpowiedzi uznanych przez użytkownika za poprawne. Jeśli na danym słowniku określona komenda dała poprawną odpowiedź i użytkownik ją zaakceptował, agent AI powinien brać to pod uwagę i w przyszłości zwrócić tę samą lub lekko zmodyfikowaną odpowiedź.

Podsumowanie

Heurystyczna natura agentów AI oznacza dla nas zarówno usprawnienie jak i niepewność w wynikach odpowiedzi, co wiąże się z brakiem powtarzalności. Konsekwencją mogą być poważne błędy przy masowej edycji danych. W środowisku takim jak Metastudio DRM może to prowadzić do zniekształcenia danych referencyjnych, a w konsekwencji do pogorszenia jakości danych w całej bazie.

Dlatego kluczowe jest, aby każda zmiana generowana przez agenta AI była czytelna, możliwa do zweryfikowania, pogrupowana i – jeśli to możliwe – przetestowana przed jej zatwierdzeniem.

Dopiero połączenie AI z ludzką kontrolą pozwala wykorzystać potencjał sztucznej inteligencji bez utraty jakości danych.

Jeśli chcesz dowiedzieć się więcej o rozwoju aplikacji MetastudioDRM, zapraszamy do rozmowy!